Einführung In der sich schnell entwickelnden Welt der künstlichen Intelligenz war die Suche nach leistungsstärkeren und vielseitigeren Architekturen eine treibende Kraft hinter einigen der aufregendsten Durchbrüche der letzten Jahre. Von den bahnbrechenden Transformer-Modellen, die die…

Schlagwort: ML

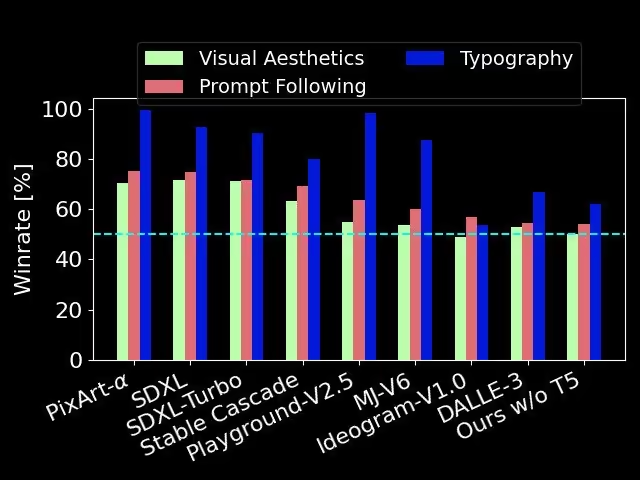

Stable Diffusion 3: Ein Quantensprung in der KI-Bildgenerierung

Stability AI hat sein neuestes Text-zu-Bild-KI-Modell, Stable Diffusion 3, veröffentlicht und damit einen bedeutenden Fortschritt im sich rasant entwickelnden Bereich der generativen KI erzielt. Das neue Modell besticht durch beeindruckende Verbesserungen bei der Bildqualität, der…

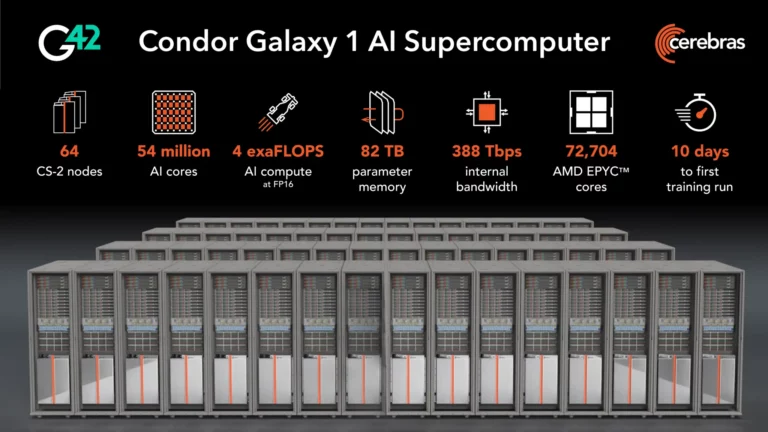

Cerebras Systems sichert Großauftrag für den weltgrößten KI-Supercomputer

Santa Clara, CA – 20. Juli 2023 – Cerebras Systems, ein führender Anbieter von KI-Lösungen auf Wafer-Ebene, hat einen Großauftrag von g42, einem in Abu Dhabi ansässigen Technologiekonglomerat, bekannt gegeben. Cerebras wird in den nächsten…

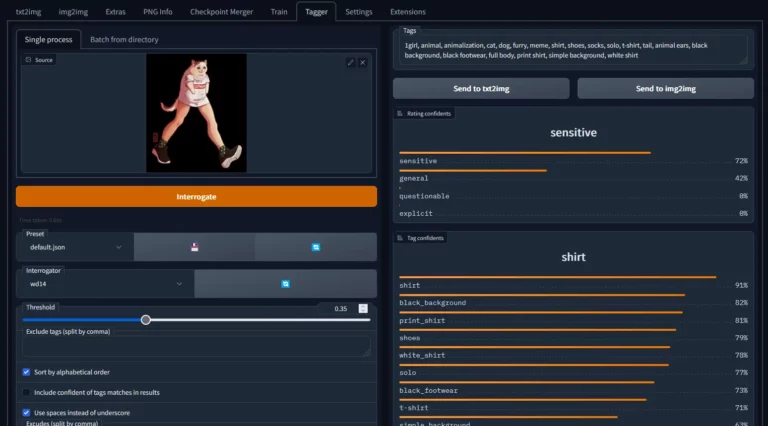

Bild-zu-Text KI-Modelle: CLIP, BLIP und WD 1.4 (auch WD14)

Die automatische Verschlagwortung, Beschriftung oder Beschreibung von Bildern ist eine entscheidende Aufgabe in vielen Anwendungen, insbesondere bei der Vorbereitung von Datensätzen für das maschinelle Lernen. Hier kommen Bild-zu-Text-Modelle zum Einsatz. Zu den führenden Bild-zu-Text-Modellen gehören…