Einführung

In der sich schnell entwickelnden Welt der künstlichen Intelligenz war die Suche nach leistungsstärkeren und vielseitigeren Architekturen eine treibende Kraft hinter einigen der aufregendsten Durchbrüche der letzten Jahre. Von den bahnbrechenden Transformer-Modellen, die die natürliche Sprachverarbeitung revolutioniert haben, bis hin zu den innovativen Joint-Embedding Predictive Architectures (JEPAs), die die Grenzen des selbstüberwachten Lernens verschieben, verändert sich die Landschaft der KI ständig und bietet neue Möglichkeiten und Herausforderungen.

In diesem umfassenden Artikel tauchen wir tief in die Welt modernster KI-Architekturen ein und untersuchen die wichtigsten Funktionen, Stärken und Anwendungen von Transformers, JEPAs und anderen hochmodernen Modellen. Ob Sie nun ein erfahrener KI-Enthusiast sind oder gerade erst anfangen, dieses faszinierende Gebiet zu erkunden, dieser Artikel bietet Ihnen einen detaillierten und zugänglichen Überblick über die neuesten Entwicklungen und hilft Ihnen, sich in der sich ständig weiterentwickelnden Landschaft der künstlichen Intelligenz zurechtzufinden.

Der Aufstieg der Transformer-Architekturen

Die Transformer-Architektur, die erstmals 2017 in dem bahnbrechenden Paper „Attention is All You Need“ von Vaswani et al. vorgestellt wurde, hat sich schnell zu einem der einflussreichsten und am weitesten verbreiteten Modelle im Bereich der natürlichen Sprachverarbeitung (NLP) entwickelt. Im Gegensatz zu herkömmlichen rekurrenten neuronalen Netzen (RNNs) und Convolutional Neural Networks (CNNs) basieren Transformers auf einem einzigartigen Mechanismus, der sogenannten „Aufmerksamkeit“, um weitreichende Abhängigkeiten und Kontextinformationen innerhalb der Eingabedaten zu erfassen.

Der Kern der Transformer-Architektur besteht aus zwei Schlüsselkomponenten: dem Encoder und dem Decoder. Der Encoder nimmt die Eingabesequenz entgegen und erzeugt einen Satz kontextbezogener Repräsentationen, während der Decoder diese Repräsentationen verwendet, um Schritt für Schritt die Ausgabesequenz zu erzeugen. Der Aufmerksamkeitsmechanismus spielt dabei eine entscheidende Rolle, da er es dem Modell ermöglicht, sich bei der Erzeugung jedes Ausgabetokens auf die relevantesten Teile der Eingabe zu konzentrieren.

Die Stärke von Transformers liegt in ihrer Fähigkeit, mit weitreichenden Abhängigkeiten umzugehen, ihrer parallelisierbaren Natur und ihrer Skalierbarkeit auf größere und komplexere Datensätze. Diese Eigenschaften haben Transformers zur ersten Wahl für eine Vielzahl von NLP-Aufgaben gemacht, von der maschinellen Übersetzung und Textzusammenfassung bis hin zur Sprachmodellierung und Fragenbeantwortung.

Erkundung von Joint-Embedding Predictive Architectures (JEPAs)

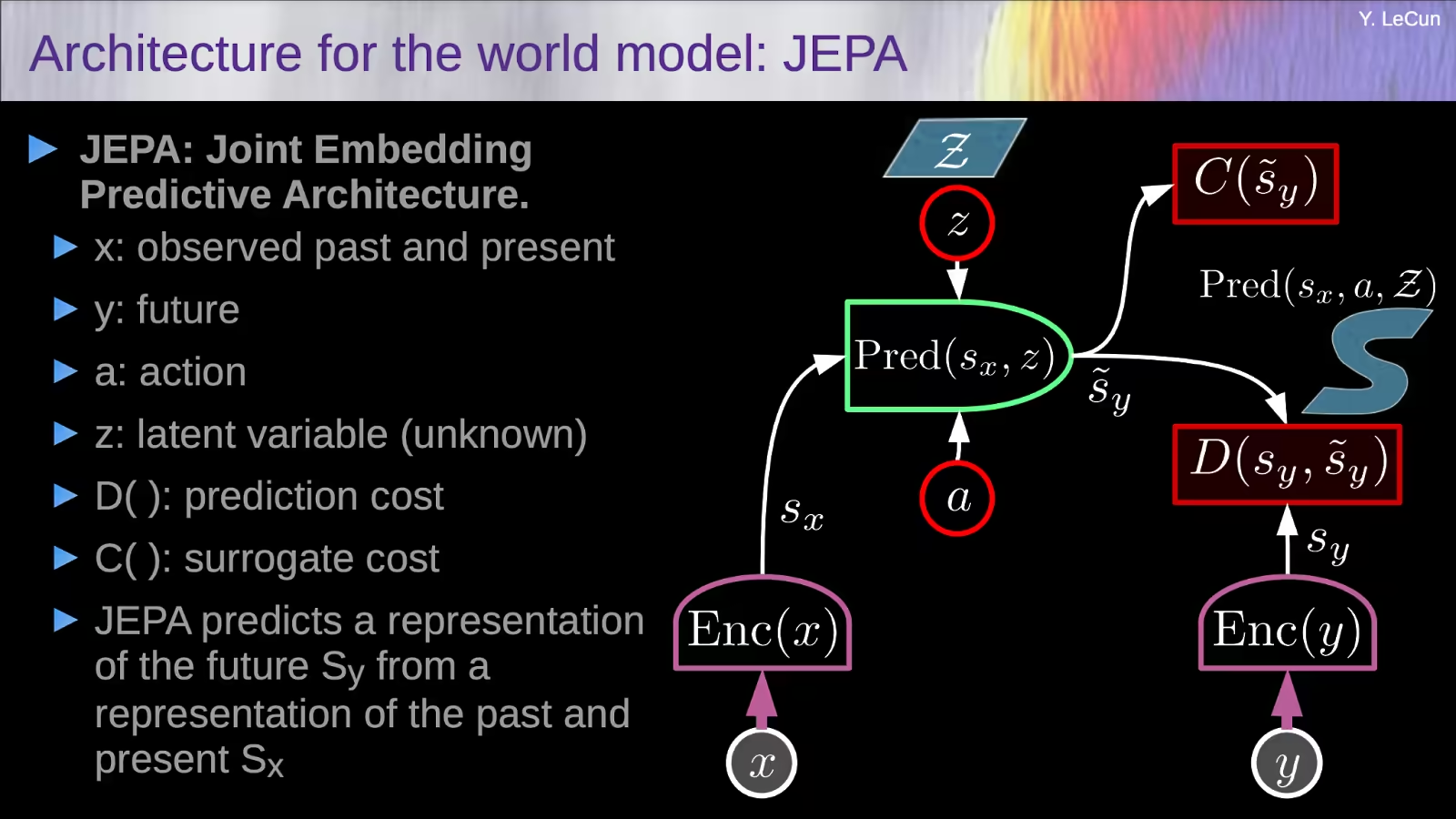

Während Transformers die NLP-Landschaft dominiert haben, ist eine neue Klasse von Architekturen entstanden, die bereit ist, das Feld des selbstüberwachten Lernens aus Bildern zu revolutionieren: Joint-Embedding Predictive Architectures (JEPAs).

Die Grundidee hinter JEPAs ist es, Repräsentationen zu lernen, die sich gegenseitig vorhersagen können, wenn zusätzliche Informationen gegeben werden, anstatt wie bei traditionellen selbstüberwachten Methoden nach Invarianz gegenüber Datenaugmentationen zu suchen. Dieser Ansatz ermutigt das Modell, aussagekräftige und hochrangige Merkmale zu erfassen, anstatt sich auf irrelevante Details auf Pixelebene zu konzentrieren.

Eines der bekanntesten Beispiele für JEPAs ist die Image-based Joint-Embedding Predictive Architecture (I-JEPA), die von Forschern von Meta AI vorgestellt wurde. I-JEPA arbeitet, indem es einen einzelnen „Kontext“-Block aus einem Bild nimmt und damit die Repräsentationen verschiedener „Ziel“-Blöcke innerhalb desselben Bildes vorhersagt. Dieser nicht-generative Ansatz ermöglicht es dem Modell, Repräsentationen auf semantischer Ebene zu lernen, ohne sich auf handgefertigte Datenaugmentationen verlassen zu müssen.

Die wichtigsten Designentscheidungen in I-JEPA, wie die Maskierungsstrategie und die Verwendung eines räumlich verteilten Kontextblocks, sind entscheidend, um das Modell zur Erzeugung aussagekräftiger und hochrangiger Repräsentationen zu führen. Empirisch hat sich gezeigt, dass I-JEPA hochgradig skalierbar ist und in der Lage ist, große Vision Transformer (ViT)-Modelle auf dem ImageNet-Datensatz in weniger als 72 Stunden zu trainieren und gleichzeitig eine starke Downstream-Performance über eine Vielzahl von Aufgaben hinweg zu erzielen.

Was sind die Hauptvorteile der Verwendung der JEPA-Architektur gegenüber herkömmlichen generativen Modellen?

Die Hauptvorteile der Verwendung von Joint-Embedding Predictive Architectures (JEPAs) gegenüber herkömmlichen generativen Modellen sind:

Priorisierung semantischer Repräsentationen gegenüber Details auf Pixelebene

Im Gegensatz zu generativen Modellen, die sich darauf konzentrieren, die Eingabedaten im Pixelraum zu rekonstruieren, lernen JEPAs Repräsentationen, die sich in einem abstrakten Einbettungsraum gegenseitig vorhersagen. Dies ermöglicht es dem Modell, die Erfassung aussagekräftiger, hochrangiger semantischer Merkmale gegenüber irrelevanten Details auf Pixelebene zu priorisieren.

Vermeidung von Repräsentationskollaps

Generative Modelle können manchmal unter einem Repräsentationskollaps leiden, bei dem das Modell keine vielfältigen und informativen Repräsentationen lernen kann. JEPAs begegnen diesem Problem durch ein asymmetrisches Design zwischen den verschiedenen Encodern, was das Lernen von Repräsentationen fördert, die sich gegenseitig vorhersagen können, wenn zusätzliche Informationen gegeben werden.

Skalierbarkeit und Effizienz

JEPAs, wie z. B. die Image-based Joint-Embedding Predictive Architecture (I-JEPA), können hochgradig skalierbar und effizient sein. I-JEPA hat beispielsweise gezeigt, dass es in der Lage ist, große Vision Transformer (ViT)-Modelle auf dem ImageNet-Datensatz in weniger als 72 Stunden zu trainieren und gleichzeitig eine starke Downstream-Performance zu erzielen.

Vielseitigkeit bei nachgelagerten Aufgaben

JEPAs haben nicht nur bei High-Level-Aufgaben wie der Bildklassifizierung, sondern auch bei Low-Level- und Dense-Prediction-Aufgaben wie der Objektzählung und der Tiefenvorhersage eine starke Leistung gezeigt. Diese Vielseitigkeit deutet darauf hin, dass die gelernten Repräsentationen sowohl semantische als auch lokale Merkmale effektiv erfassen können.

Die Hauptvorteile von JEPAs gegenüber herkömmlichen generativen Modellen liegen in ihrer Fähigkeit, semantische Repräsentationen zu priorisieren, einen Repräsentationskollaps zu vermeiden, Skalierbarkeit und Effizienz zu erreichen und Vielseitigkeit über eine breite Palette von nachgelagerten Aufgaben hinweg zu demonstrieren. Diese Eigenschaften machen JEPAs zu einem vielversprechenden Ansatz, um den Stand der Technik im Bereich des selbstüberwachten Lernens voranzutreiben und leistungsfähigere und anpassungsfähigere KI-Systeme zu entwickeln.

Wie geht die Transformer-Architektur im Vergleich zur JEPA-Architektur mit multimodalen Daten um?

Hier ist ein Vergleich, wie die Transformer-Architektur und die Joint-Embedding Predictive Architecture (JEPA) mit multimodalen Daten umgehen:

Transformer-Architektur für multimodale Daten

- Transformers wurden ursprünglich für Aufgaben der natürlichen Sprachverarbeitung entwickelt, wurden aber auch für die Verarbeitung multimodaler Daten erweitert.

- Multimodale Transformer-Modelle kodieren typischerweise verschiedene Modalitäten (z. B. Text, Bilder, Audio) separat mithilfe modalitätsspezifischer Encoder und kombinieren die kodierten Repräsentationen dann mithilfe von Fusionsmechanismen wie Verkettung oder Aufmerksamkeit.

- Dies ermöglicht es Transformer-Modellen, die Interaktionen und Beziehungen zwischen den verschiedenen Modalitäten effektiv zu erfassen.

- Beispiele für multimodale Transformer-Modelle sind VilBERT, VisualBERT und UNITER, die für Aufgaben wie die Beantwortung visueller Fragen und den Bild-Text-Abruf eingesetzt wurden.

JEPA-Architektur für multimodale Daten

- Der JEPA (Joint-Embedding Predictive Architecture)-Ansatz, der durch das Image-based JEPA (I-JEPA)-Modell veranschaulicht wird, konzentriert sich auf das Lernen von Repräsentationen aus einer einzigen Modalität (in diesem Fall Bilder).

- I-JEPA lernt diese Repräsentationen, indem es die Repräsentationen verschiedener „Ziel“-Bildblöcke aus einem einzelnen „Kontext“-Block vorhersagt, ohne sich auf handgefertigte Datenaugmentationen zu verlassen.

- Während I-JEPA bisher nicht explizit für die Verarbeitung multimodaler Daten erweitert wurde, könnte das JEPA-Kernkonzept des Lernens prädiktiver Repräsentationen potenziell auch auf andere Modalitäten wie Text oder Audio angewendet werden.

- Zukünftige Arbeiten könnten sich mit der Erweiterung von JEPA befassen, um gemeinsame Repräsentationen über mehrere Modalitäten hinweg zu lernen, ähnlich wie es bei Transformer-basierten multimodalen Modellen der Fall ist.

Die Transformer-Architektur ist expliziter für die Verarbeitung multimodaler Daten konzipiert, indem jede Modalität separat kodiert und die Repräsentationen anschließend fusioniert werden, während sich der JEPA-Ansatz bisher auf das Lernen von Repräsentationen aus einer einzigen Modalität konzentriert hat. Der prädiktive Charakter von JEPA könnte es jedoch zu einem vielversprechenden Kandidaten für die Entwicklung multimodaler Architekturen in der Zukunft machen.

Mamba-Architektur: Ein hybrider Ansatz

Während Transformers und JEPAs in ihren jeweiligen Domänen bedeutende Fortschritte gemacht haben, wächst das Interesse an der Erforschung hybrider Architekturen, die die Stärken mehrerer Ansätze kombinieren. Ein Beispiel hierfür ist die Mamba-Architektur, die darauf abzielt, das Beste aus beiden Welten zu nutzen.

Mamba, benannt nach der agilen und anpassungsfähigen Schlange, ist eine hybride Architektur, die die aufmerksamkeitsbasierten Mechanismen von Transformers mit den Joint-Embedding-Vorhersagefähigkeiten von JEPAs integriert. Durch die Kombination dieser beiden leistungsstarken Paradigmen zielt Mamba darauf ab, ein vielseitigeres und robusteres Modell zu schaffen, das sich für eine breite Palette von Aufgaben eignet, von der Verarbeitung natürlicher Sprache bis hin zur Computer Vision und darüber hinaus.

Die Mamba-Architektur ist so konzipiert, dass sie in hohem Maße modular ist, was die nahtlose Integration verschiedener Komponenten und die einfache Anpassung an verschiedene Datenmodalitäten und Problemdomänen ermöglicht. Diese Flexibilität macht Mamba zu einem vielversprechenden Kandidaten für die Entwicklung echter „generalistischer“ KI-Modelle, die in der Lage sind, eine Vielzahl von Aufgaben und Herausforderungen zu bewältigen.

Der Stand der Technik bei multimodalen KI-Architekturen

Mit der Weiterentwicklung des Bereichs der künstlichen Intelligenz ist der Bedarf an Modellen, die mehrere Datenmodalitäten wie Text, Bilder, Audio und Video effektiv verarbeiten und integrieren können, immer deutlicher geworden. Dies hat zur Entstehung multimodaler KI-Architekturen geführt, die darauf abzielen, die komplementären Informationen aus verschiedenen Datenquellen zu nutzen, um die Gesamtleistung und die Fähigkeiten des Systems zu verbessern.

Eine der zentralen Herausforderungen bei der Entwicklung multimodaler KI-Architekturen ist die effektive Fusion und Repräsentation der verschiedenen Datenmodalitäten. Forscher haben eine Reihe von Ansätzen untersucht, von der einfachen Verkettung unimodaler Merkmale bis hin zu ausgefeilteren Techniken wie aufmerksamkeitsbasierter Fusion und multimodaler Interaktion.

Nennenswerte Beispiele für hochmoderne multimodale KI-Architekturen sind der Meshed-Memory Transformer for Image Captioning (M2 Transformer), der die Leistung von Transformers mit einem neuartigen speicherbasierten Mechanismus kombiniert, um sowohl die Bildkodierung als auch die Sprachgenerierung zu verbessern. Ein weiteres Beispiel ist das ImageBind-Modell von Meta AI, das darauf abzielt, einen einheitlichen Einbettungsraum zu schaffen, der verschiedene visuelle und textuelle Modalitäten miteinander verbinden kann.

Mit dem Fortschritt im Bereich der multimodalen KI können wir mit noch innovativeren und vielseitigeren Architekturen rechnen, die eine breite Palette von Datenquellen nahtlos integrieren und verarbeiten können und so den Weg für die Entwicklung wirklich generalistischer KI-Systeme ebnen.

Zusammenfassung

Die Welt der künstlichen Intelligenz befindet sich in einem ständigen Wandel, und in rasantem Tempo entstehen neue und aufregende Architekturen. Von den bahnbrechenden Transformer-Modellen, die die Verarbeitung natürlicher Sprache revolutioniert haben, bis hin zu den innovativen Joint-Embedding Predictive Architectures, die die Grenzen des selbstüberwachten Lernens verschieben, entwickelt sich die Landschaft der KI ständig weiter und bietet neue Möglichkeiten und Herausforderungen.

In diesem Artikel haben wir die wichtigsten Merkmale, Stärken und Anwendungen dieser hochmodernen Architekturen sowie die aufkommenden Trends im Bereich der multimodalen KI untersucht. Während wir die Grenzen des Möglichen im Bereich der künstlichen Intelligenz weiter verschieben, ist klar, dass die Zukunft noch bemerkenswertere Fortschritte bereithält, die die Art und Weise, wie wir mit der Welt um uns herum interagieren und sie verstehen, verändern werden.

Ob Sie nun ein erfahrener KI-Enthusiast sind oder gerade erst anfangen, dieses faszinierende Gebiet zu erkunden, dieser Artikel hat Ihnen einen detaillierten und zugänglichen Überblick über die neuesten Entwicklungen gegeben und Sie mit dem Wissen und den Erkenntnissen ausgestattet, die Sie benötigen, um sich in der sich ständig weiterentwickelnden Landschaft der künstlichen Intelligenz zurechtzufinden.