Dans le monde en constante évolution de l’intelligence artificielle, la quête d’architectures plus puissantes et plus polyvalentes a été le moteur de certaines des percées les plus passionnantes de ces dernières années. Des modèles révolutionnaires de Transformers qui ont révolutionné le traitement du langage naturel aux architectures prédictives à intégration conjointe (JEPA) innovantes qui repoussent les limites de l’apprentissage auto-supervisé, le paysage de l’IA est en constante mutation, offrant de nouvelles possibilités et de nouveaux défis.

Dans cet article complet, nous allons plonger dans le monde des architectures d’IA de pointe, en explorant les caractéristiques clés, les forces et les applications des Transformers, des JEPA et d’autres modèles de pointe. Que vous soyez un passionné d’IA chevronné ou que vous commenciez tout juste à explorer ce domaine fascinant, cet article vous fournira un aperçu détaillé et accessible des dernières avancées, vous aidant à naviguer dans le paysage en constante évolution de l’intelligence artificielle.

L’essor des architectures de Transformers

L’architecture Transformer, introduite pour la première fois dans l’article révolutionnaire « Attention is All You Need » par Vaswani et al. en 2017, est rapidement devenue l’un des modèles les plus influents et les plus largement adoptés dans le domaine du traitement du langage naturel (TLN). Contrairement aux réseaux neuronaux récurrents (RNN) et aux réseaux neuronaux convolutifs (CNN) traditionnels, les Transformers s’appuient sur un mécanisme unique appelé « attention » pour capturer les dépendances à longue portée et les informations contextuelles au sein des données d’entrée.

Au cœur de l’architecture Transformer se trouvent deux composants clés : l’encodeur et le décodeur. L’encodeur prend la séquence d’entrée et génère un ensemble de représentations contextuelles, tandis que le décodeur utilise ces représentations pour générer la séquence de sortie, étape par étape. Le mécanisme d’attention joue un rôle crucial dans ce processus, permettant au modèle de se concentrer sur les parties les plus pertinentes de l’entrée lors de la génération de chaque jeton de sortie.

La puissance des Transformers réside dans leur capacité à gérer les dépendances à longue portée, leur nature parallélisable et leur évolutivité à des ensembles de données plus importants et plus complexes. Ces caractéristiques ont fait des Transformers le choix de prédilection pour un large éventail de tâches de TLN, de la traduction automatique au résumé de texte en passant par la modélisation linguistique et la réponse aux questions.

Explorer les architectures prédictives à intégration conjointe (JEPA)

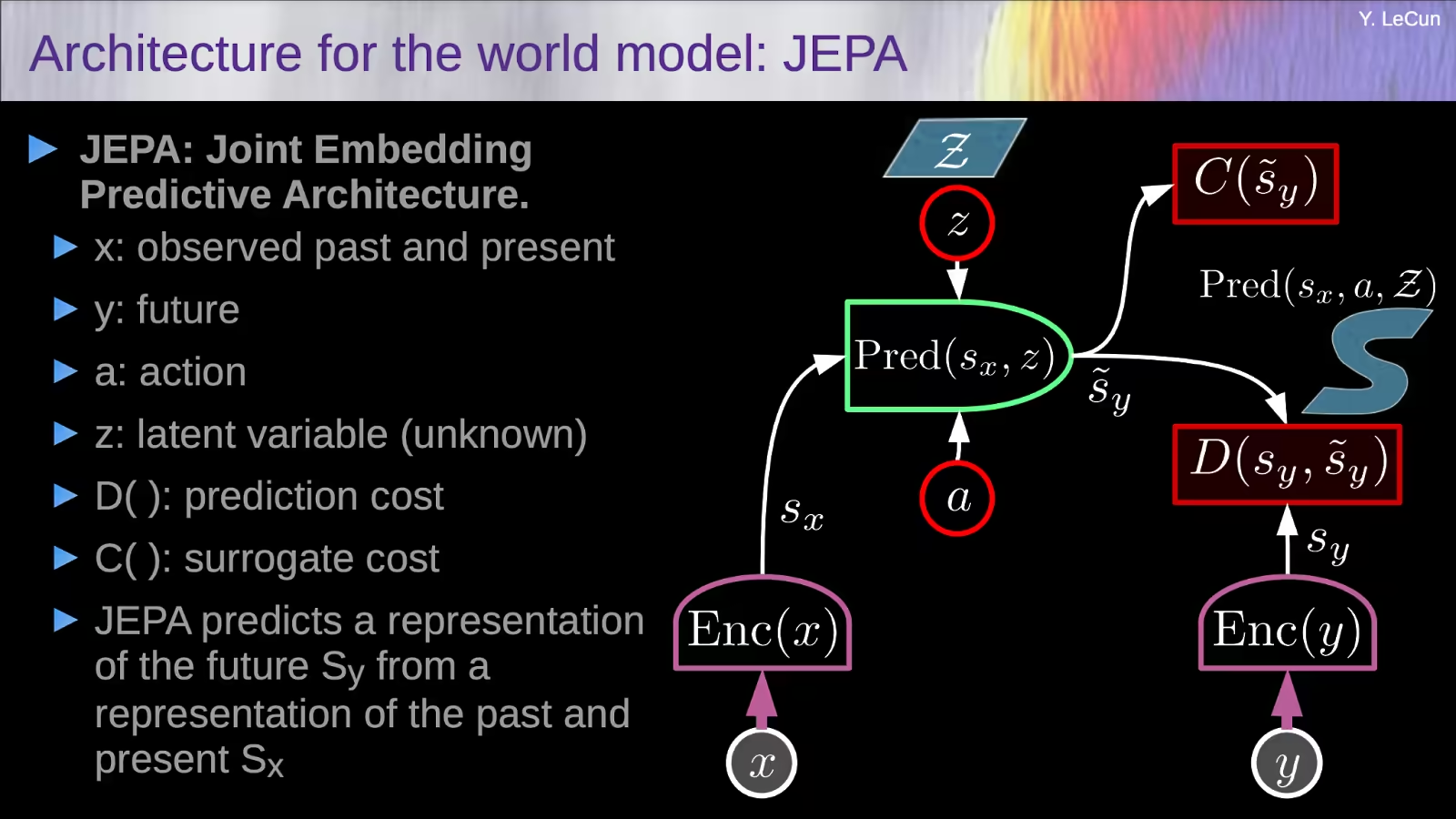

Alors que les Transformers ont dominé le paysage du TLN, une nouvelle classe d’architectures a émergé, qui est sur le point de révolutionner le domaine de l’apprentissage auto-supervisé à partir d’images : les architectures prédictives à intégration conjointe (JEPA).

L’idée clé derrière les JEPA est d’apprendre des représentations qui peuvent se prédire mutuellement lorsque des informations supplémentaires sont fournies, plutôt que de rechercher l’invariance aux augmentations de données comme les méthodes auto-supervisées traditionnelles. Cette approche encourage le modèle à capturer des caractéristiques significatives et de haut niveau, plutôt que de se concentrer sur des détails non pertinents au niveau des pixels.

L’un des exemples les plus marquants des JEPA est l’architecture prédictive à intégration conjointe basée sur l’image (I-JEPA), introduite par des chercheurs de Meta AI. I-JEPA fonctionne en prenant un seul bloc « contexte » d’une image et en l’utilisant pour prédire les représentations de divers blocs « cible » au sein de la même image. Cette approche non générative permet au modèle d’apprendre des représentations au niveau sémantique sans s’appuyer sur des augmentations de données artisanales.

Les choix de conception clés d’I-JEPA, tels que la stratégie de masquage et l’utilisation d’un bloc de contexte spatialement distribué, sont cruciaux pour guider le modèle vers la génération de représentations significatives et de haut niveau. Sur le plan empirique, il a été démontré qu’I-JEPA est hautement évolutif, avec la capacité d’entraîner de grands modèles Vision Transformer (ViT) sur l’ensemble de données ImageNet en moins de 72 heures tout en atteignant de solides performances en aval sur un large éventail de tâches.

Quels sont les principaux avantages de l’utilisation de l’architecture JEPA par rapport aux modèles génératifs traditionnels ?

Les principaux avantages de l’utilisation des architectures prédictives à intégration conjointe (JEPA) par rapport aux modèles génératifs traditionnels sont les suivants :

Prioriser les représentations sémantiques plutôt que les détails au niveau des pixels

Contrairement aux modèles génératifs qui se concentrent sur la reconstruction des données d’entrée dans l’espace des pixels, les JEPA apprennent des représentations qui se prédisent mutuellement dans un espace d’intégration abstrait. Cela permet au modèle de donner la priorité à la capture de caractéristiques sémantiques significatives et de haut niveau plutôt qu’à des détails non pertinents au niveau des pixels.

Éviter l’effondrement des représentations

Les modèles génératifs peuvent parfois souffrir d’un effondrement des représentations, c’est-à-dire que le modèle ne parvient pas à apprendre des représentations diverses et informatives. Les JEPA répondent à ce problème en utilisant une conception asymétrique entre les différents encodeurs, ce qui encourage l’apprentissage de représentations qui peuvent se prédire mutuellement lorsque des informations supplémentaires sont fournies.

Évolutivité et efficacité

Les JEPA, comme l’architecture prédictive à intégration conjointe basée sur l’image (I-JEPA), peuvent être très évolutives et efficaces. I-JEPA, par exemple, a démontré sa capacité à former de grands modèles Vision Transformer (ViT) sur l’ensemble de données ImageNet en moins de 72 heures tout en obtenant de solides performances en aval.

Polyvalence dans les tâches en aval

Les JEPA ont démontré de solides performances non seulement dans des tâches de haut niveau comme la classification d’images, mais aussi dans des tâches de bas niveau et de prédiction dense, comme le comptage d’objets et la prédiction de la profondeur. Cette polyvalence suggère que les représentations apprises peuvent capturer efficacement les caractéristiques sémantiques et locales.

Les principaux avantages des JEPA par rapport aux modèles génératifs traditionnels sont leur capacité à donner la priorité aux représentations sémantiques, à éviter l’effondrement des représentations, à atteindre l’évolutivité et l’efficacité, et à démontrer leur polyvalence dans un large éventail de tâches en aval. Ces propriétés font des JEPA une approche prometteuse pour faire progresser l’état de l’art en matière d’apprentissage auto-supervisé et pour construire des systèmes d’IA plus performants et plus adaptables.

Comment l’architecture Transformer gère-t-elle les données multimodales par rapport à l’architecture JEPA ?

Voici une comparaison de la manière dont l’architecture Transformer et l’architecture prédictive à intégration conjointe (JEPA) gèrent les données multimodales :

Architecture Transformer pour les données multimodales

- Les Transformers ont été initialement développés pour les tâches de traitement du langage naturel, mais ils ont été étendus pour gérer également les données multimodales.

- Les modèles Transformer multimodaux encodent généralement les différentes modalités (par exemple, texte, images, audio) séparément à l’aide d’encodeurs spécifiques à la modalité, puis combinent les représentations encodées à l’aide de mécanismes de fusion tels que la concaténation ou l’attention.

- Cela permet aux modèles Transformer de capturer efficacement les interactions et les relations entre les différentes modalités.

- Parmi les exemples de modèles Transformer multimodaux, citons VilBERT, VisualBERT et UNITER, qui ont été appliqués à des tâches telles que la réponse aux questions visuelles et la recherche d’images à partir de texte.

Architecture JEPA pour les données multimodales

- L’approche JEPA (Joint-Embedding Predictive Architecture), illustrée par le modèle I-JEPA (Image-based JEPA), se concentre sur l’apprentissage de représentations à partir d’une seule modalité (en l’occurrence, les images).

- I-JEPA apprend ces représentations en prédisant les représentations de divers blocs d’images « cibles » à partir d’un seul bloc « contexte », sans s’appuyer sur des augmentations de données artisanales.

- Bien que I-JEPA n’ait pas encore été explicitement étendu pour gérer les données multimodales, le concept central de JEPA, qui consiste à apprendre des représentations prédictives, pourrait potentiellement être appliqué à d’autres modalités comme le texte ou l’audio.

- Les travaux futurs pourraient explorer la possibilité d’étendre JEPA à l’apprentissage de représentations conjointes sur plusieurs modalités, de la même manière que les modèles multimodaux basés sur Transformer.

L’architecture Transformer est plus explicitement conçue pour gérer les données multimodales en encodant chaque modalité séparément, puis en fusionnant les représentations, tandis que l’approche JEPA s’est jusqu’à présent concentrée sur l’apprentissage de représentations à partir d’une seule modalité. Cependant, la nature prédictive de JEPA pourrait en faire un candidat prometteur pour le développement d’architectures multimodales à l’avenir.

Architecture Mamba : une approche hybride

Alors que les Transformers et les JEPA ont fait des progrès significatifs dans leurs domaines respectifs, on observe un intérêt croissant pour l’exploration d’architectures hybrides qui combinent les forces de multiples approches. L’architecture Mamba, qui vise à tirer parti du meilleur des deux mondes, en est un exemple.

Mamba, nommé d’après le serpent agile et adaptable, est une architecture hybride qui intègre les mécanismes basés sur l’attention des Transformers aux capacités prédictives d’intégration conjointe des JEPA. En combinant ces deux paradigmes puissants, Mamba cherche à créer un modèle plus polyvalent et plus robuste, capable d’exceller dans un large éventail de tâches, du traitement du langage naturel à la vision par ordinateur et au-delà.

L’architecture Mamba est conçue pour être hautement modulaire, ce qui permet d’intégrer de manière transparente différents composants et de s’adapter facilement à diverses modalités de données et domaines problématiques. Cette flexibilité fait de Mamba un candidat prometteur pour le développement de modèles d’IA véritablement « généralistes », capables de s’attaquer à un large éventail de tâches et de défis.

L’état de l’art des architectures d’IA multimodales

À mesure que le domaine de l’intelligence artificielle continue d’évoluer, le besoin de modèles capables de gérer et d’intégrer efficacement plusieurs modalités de données, telles que le texte, les images, l’audio et la vidéo, est devenu de plus en plus évident. Cela a donné naissance à l’émergence d’architectures d’IA multimodales, qui visent à tirer parti des informations complémentaires provenant de différentes sources de données pour améliorer les performances et les capacités globales du système.

L’un des principaux défis du développement d’architectures d’IA multimodales est la fusion et la représentation efficaces des différentes modalités de données. Les chercheurs ont exploré toute une série d’approches, allant de la simple concaténation de caractéristiques unimodales à des techniques plus sophistiquées telles que la fusion basée sur l’attention et l’interaction intermodale.

Parmi les exemples notables d’architectures d’IA multimodales de pointe, citons le Meshed-Memory Transformer for Image Captioning (M2 Transformer), qui combine la puissance des Transformers à un nouveau mécanisme basé sur la mémoire pour améliorer à la fois l’encodage des images et la génération du langage. Un autre exemple est le modèle ImageBind de Meta AI, qui vise à créer un espace d’intégration unifié capable de lier diverses modalités visuelles et textuelles.

À mesure que le domaine de l’IA multimodale continue de progresser, nous pouvons nous attendre à voir apparaître des architectures encore plus innovantes et polyvalentes, capables d’intégrer et de traiter de manière transparente un large éventail de sources de données, ouvrant ainsi la voie au développement de systèmes d’IA véritablement généralistes.

Conclusion

Le monde de l’intelligence artificielle est en constante évolution, avec l’émergence rapide d’architectures nouvelles et passionnantes. Des modèles Transformer révolutionnaires qui ont révolutionné le traitement du langage naturel aux architectures prédictives à intégration conjointe innovantes qui repoussent les limites de l’apprentissage auto-supervisé, le paysage de l’IA est en constante évolution, offrant de nouvelles possibilités et de nouveaux défis.

Dans cet article, nous avons exploré les caractéristiques clés, les forces et les applications de ces architectures de pointe, ainsi que les tendances émergentes de l’IA multimodale. Alors que nous continuons à repousser les limites du possible dans le domaine de l’intelligence artificielle, il est clair que l’avenir nous réserve des avancées encore plus remarquables, qui transformeront la façon dont nous interagissons avec le monde qui nous entoure et dont nous le comprenons.

Que vous soyez un passionné d’IA chevronné ou que vous commenciez tout juste à explorer ce domaine fascinant, cet article vous a fourni un aperçu détaillé et accessible des dernières avancées, vous dotant ainsi des connaissances et des idées nécessaires pour naviguer dans le paysage en constante évolution de l’intelligence artificielle.