Introducción

En el mundo de la inteligencia artificial en rápida evolución, la búsqueda de arquitecturas más potentes y versátiles ha sido una fuerza impulsora detrás de algunos de los avances más emocionantes de los últimos años. Desde los innovadores modelos Transformer que han revolucionado el procesamiento del lenguaje natural hasta las innovadoras Joint-Embedding Predictive Architectures (JEPAs) que están ampliando los límites del aprendizaje autosupervisado, el panorama de la IA cambia constantemente y ofrece nuevas posibilidades y desafíos.

En este artículo completo, nos adentraremos en el mundo de las arquitecturas de IA de vanguardia, explorando las características clave, las fortalezas y las aplicaciones de Transformers, JEPAs y otros modelos de vanguardia. Tanto si eres un entusiasta experimentado en IA como si estás empezando a explorar este fascinante campo, este artículo te proporcionará una descripción general detallada y accesible de los últimos avances, ayudándote a navegar por el panorama en constante evolución de la inteligencia artificial.

El auge de las arquitecturas Transformer

La arquitectura Transformer, presentada por primera vez en el innovador artículo «Attention is All You Need» de Vaswani et al. en 2017, se ha convertido rápidamente en uno de los modelos más influyentes y ampliamente adoptados en el campo del procesamiento del lenguaje natural (PNL). A diferencia de las redes neuronales recurrentes (RNN) y las redes neuronales convolucionales (CNN) tradicionales, los Transformers se basan en un mecanismo único llamado «atención» para capturar dependencias de largo alcance e información contextual dentro de los datos de entrada.

En el núcleo de la arquitectura Transformer se encuentran dos componentes clave: el codificador y el decodificador. El codificador toma la secuencia de entrada y genera un conjunto de representaciones contextuales, mientras que el decodificador utiliza estas representaciones para generar la secuencia de salida, paso a paso. El mecanismo de atención juega un papel crucial en este proceso, permitiendo que el modelo se centre en las partes más relevantes de la entrada al generar cada token de salida.

El poder de los Transformers reside en su capacidad para manejar dependencias de largo alcance, su naturaleza paralelizable y su escalabilidad a conjuntos de datos más grandes y complejos. Estas características han convertido a los Transformers en la opción preferida para una amplia gama de tareas de PNL, desde la traducción automática y el resumen de texto hasta el modelado del lenguaje y la respuesta a preguntas.

Explorando las Joint-Embedding Predictive Architectures (JEPAs)

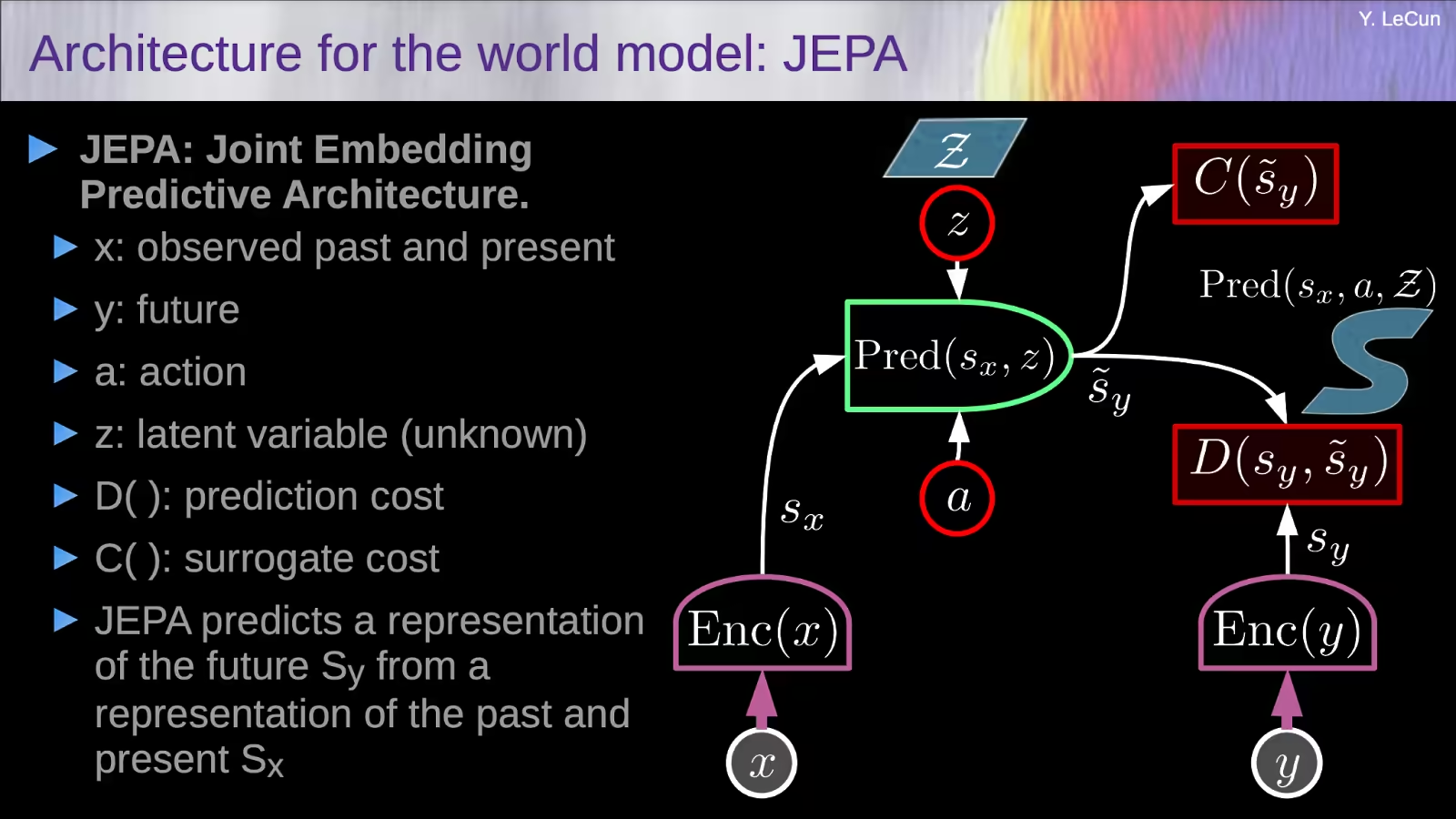

Mientras que los Transformers han dominado el panorama del PNL, ha surgido una nueva clase de arquitecturas que está preparada para revolucionar el campo del aprendizaje autosupervisado a partir de imágenes: las Joint-Embedding Predictive Architectures (JEPAs).

La idea clave detrás de las JEPAs es aprender representaciones que puedan predecirse entre sí cuando se proporciona información adicional, en lugar de buscar la invariancia a los aumentos de datos como los métodos autosupervisados tradicionales. Este enfoque anima al modelo a capturar características significativas y de alto nivel, en lugar de centrarse en detalles irrelevantes a nivel de píxeles.

Uno de los ejemplos más destacados de JEPAs es la Image-based Joint-Embedding Predictive Architecture (I-JEPA), presentada por investigadores de Meta AI. I-JEPA funciona tomando un único bloque de «contexto» de una imagen y utilizándolo para predecir las representaciones de varios bloques «objetivo» dentro de la misma imagen. Este enfoque no generativo permite que el modelo aprenda representaciones a nivel semántico sin depender de aumentos de datos artesanales.

Las decisiones de diseño clave en I-JEPA, como la estrategia de enmascaramiento y el uso de un bloque de contexto espacialmente distribuido, son cruciales para guiar al modelo hacia la generación de representaciones significativas y de alto nivel. Empíricamente, se ha demostrado que I-JEPA es altamente escalable, con la capacidad de entrenar grandes modelos Vision Transformer (ViT) en el conjunto de datos ImageNet en menos de 72 horas, al tiempo que logra un sólido rendimiento posterior en una amplia gama de tareas.

¿Cuáles son las ventajas clave de utilizar la arquitectura JEPA sobre los modelos generativos tradicionales?

Las ventajas clave de utilizar Joint-Embedding Predictive Architectures (JEPAs) sobre los modelos generativos tradicionales son:

Priorizar las representaciones semánticas sobre los detalles a nivel de píxeles

A diferencia de los modelos generativos que se centran en reconstruir los datos de entrada en el espacio de píxeles, las JEPAs aprenden representaciones que se predicen entre sí en un espacio de incrustación abstracto. Esto permite que el modelo dé prioridad a la captura de características semánticas significativas y de alto nivel sobre los detalles irrelevantes a nivel de píxeles.

Evitar el colapso de la representación

Los modelos generativos a veces pueden sufrir un colapso de la representación, donde el modelo no logra aprender representaciones diversas e informativas. Las JEPAs abordan este problema utilizando un diseño asimétrico entre los diferentes codificadores, lo que fomenta el aprendizaje de representaciones que pueden predecirse entre sí cuando se proporciona información adicional.

Escalabilidad y eficiencia

Las JEPAs, como la Image-based Joint-Embedding Predictive Architecture (I-JEPA), pueden ser altamente escalables y eficientes. I-JEPA, por ejemplo, ha demostrado entrenar grandes modelos Vision Transformer (ViT) en el conjunto de datos ImageNet en menos de 72 horas, al tiempo que logra un sólido rendimiento posterior.

Versatilidad en tareas posteriores

Las JEPAs han demostrado un sólido rendimiento no solo en tareas de alto nivel como la clasificación de imágenes, sino también en tareas de bajo nivel y predicción densa, como el recuento de objetos y la predicción de profundidad. Esta versatilidad sugiere que las representaciones aprendidas pueden capturar eficazmente tanto las características semánticas como las locales.

Las ventajas clave de las JEPAs sobre los modelos generativos tradicionales son su capacidad para priorizar las representaciones semánticas, evitar el colapso de la representación, lograr escalabilidad y eficiencia, y demostrar versatilidad en una amplia gama de tareas posteriores. Estas propiedades hacen de las JEPAs un enfoque prometedor para avanzar en el estado del arte en el aprendizaje autosupervisado y construir sistemas de IA más capaces y adaptables.

¿Cómo maneja la arquitectura Transformer los datos multimodales en comparación con la arquitectura JEPA?

Aquí hay una comparación de cómo la arquitectura Transformer y la Joint-Embedding Predictive Architecture (JEPA) manejan los datos multimodales:

Arquitectura Transformer para datos multimodales

- Los Transformers se desarrollaron originalmente para tareas de procesamiento del lenguaje natural, pero se han ampliado para manejar también datos multimodales.

- Los modelos Transformer multimodales suelen codificar diferentes modalidades (por ejemplo, texto, imágenes, audio) por separado utilizando codificadores específicos de la modalidad y, a continuación, combinan las representaciones codificadas utilizando mecanismos de fusión como la concatenación o la atención.

- Esto permite que los modelos Transformer capturen eficazmente las interacciones y relaciones entre las diferentes modalidades.

- Algunos ejemplos de modelos Transformer multimodales son VilBERT, VisualBERT y UNITER, que se han aplicado a tareas como la respuesta a preguntas visuales y la recuperación de imágenes y texto.

Arquitectura JEPA para datos multimodales

- El enfoque JEPA (Joint-Embedding Predictive Architecture), ejemplificado por el modelo Image-based JEPA (I-JEPA), se centra en aprender representaciones a partir de una única modalidad (en este caso, imágenes).

- I-JEPA aprende estas representaciones prediciendo las representaciones de varios bloques de imágenes «objetivo» a partir de un único bloque de «contexto», sin depender de aumentos de datos artesanales.

- Aunque I-JEPA no se ha ampliado explícitamente para manejar datos multimodales todavía, el concepto básico de JEPA de aprender representaciones predictivas podría aplicarse potencialmente a otras modalidades como el texto o el audio.

- El trabajo futuro podría explorar la ampliación de JEPA para aprender representaciones conjuntas a través de múltiples modalidades, de forma similar a como funcionan los modelos multimodales basados en Transformer.

La arquitectura Transformer está más explícitamente diseñada para manejar datos multimodales codificando cada modalidad por separado y luego fusionando las representaciones, mientras que el enfoque JEPA se ha centrado hasta ahora en aprender representaciones a partir de una única modalidad. Sin embargo, la naturaleza predictiva de JEPA podría convertirla en un candidato prometedor para desarrollar arquitecturas multimodales en el futuro.

Arquitectura Mamba: un enfoque híbrido

Mientras que los Transformers y las JEPAs han hecho progresos significativos en sus respectivos dominios, existe un creciente interés en explorar arquitecturas híbridas que combinen los puntos fuertes de múltiples enfoques. Un ejemplo de ello es la arquitectura Mamba, que pretende aprovechar lo mejor de ambos mundos.

Mamba, llamada así por la ágil y adaptable serpiente, es una arquitectura híbrida que integra los mecanismos basados en la atención de los Transformers con las capacidades predictivas de incrustación conjunta de las JEPAs. Al combinar estos dos poderosos paradigmas, Mamba busca crear un modelo más versátil y robusto que pueda sobresalir en una amplia gama de tareas, desde el procesamiento del lenguaje natural hasta la visión artificial y más allá.

La arquitectura Mamba está diseñada para ser altamente modular, lo que permite la integración perfecta de diferentes componentes y la fácil adaptación a diversas modalidades de datos y dominios de problemas. Esta flexibilidad convierte a Mamba en un candidato prometedor para el desarrollo de modelos de IA verdaderamente «generalistas», capaces de abordar una amplia gama de tareas y retos.

El estado del arte en arquitecturas de IA multimodales

A medida que el campo de la inteligencia artificial sigue evolucionando, la necesidad de modelos que puedan manejar e integrar eficazmente múltiples modalidades de datos, como texto, imágenes, audio y vídeo, se ha hecho cada vez más evidente. Esto ha dado lugar a la aparición de arquitecturas de IA multimodales, que pretenden aprovechar la información complementaria de diferentes fuentes de datos para mejorar el rendimiento general y las capacidades del sistema.

Uno de los principales retos en el desarrollo de arquitecturas de IA multimodales es la fusión eficaz y la representación de las distintas modalidades de datos. Los investigadores han explorado una serie de enfoques, desde la simple concatenación de características unimodales hasta técnicas más sofisticadas como la fusión basada en la atención y la interacción cross-modal.

Entre los ejemplos más notables de arquitecturas de IA multimodales de última generación se encuentran el Meshed-Memory Transformer for Image Captioning (M2 Transformer), que combina la potencia de los Transformers con un novedoso mecanismo basado en la memoria para mejorar tanto la codificación de imágenes como la generación de lenguaje. Otro ejemplo es el modelo ImageBind de Meta AI, que pretende crear un espacio de incrustación unificado que pueda vincular varias modalidades visuales y textuales.

A medida que el campo de la IA multimodal siga avanzando, podemos esperar ver arquitecturas aún más innovadoras y versátiles que puedan integrar y procesar sin problemas una amplia gama de fuentes de datos, allanando el camino para el desarrollo de sistemas de IA verdaderamente generalistas.

En resumen

El mundo de la inteligencia artificial se encuentra en un estado de cambio constante, con nuevas y emocionantes arquitecturas que surgen a un ritmo acelerado. Desde los innovadores modelos Transformer que han revolucionado el procesamiento del lenguaje natural hasta las innovadoras Joint-Embedding Predictive Architectures que están ampliando los límites del aprendizaje autosupervisado, el panorama de la IA evoluciona constantemente y ofrece nuevas posibilidades y desafíos.

En este artículo, hemos explorado las características clave, las ventajas y las aplicaciones de estas arquitecturas de vanguardia, así como las tendencias emergentes en la IA multimodal. A medida que seguimos ampliando los límites de lo que es posible en el campo de la inteligencia artificial, está claro que el futuro nos depara avances aún más notables, transformando la forma en que interactuamos con el mundo que nos rodea y lo comprendemos.

Tanto si eres un entusiasta experimentado en IA como si estás empezando a explorar este fascinante campo, este artículo te ha proporcionado una descripción general detallada y accesible de los últimos avances, dotándote de los conocimientos y la información necesarios para navegar por el panorama en constante evolución de la inteligencia artificial.