مقدمة

يشهد عالم الذكاء الاصطناعي تطوراً سريعاً، ويُعدّ السعي وراء معماريات أكثر قوةً وتنوعاً هو القوة الدافعة وراء بعض أكثر الإنجازات إثارة في السنوات الأخيرة. بدءاً من نماذج المحولات (Transformers) الرائدة التي أحدثت ثورة في معالجة اللغات الطبيعية، ووصولاً إلى معماريات التضمين المشترك التنبؤية (JEPAs) المبتكرة التي تدفع بحدود التعلم الذاتي غير الخاضع للإشراف، تتغير معالم الذكاء الاصطناعي باستمرار، مما يُتيح إمكانيات وتحديات جديدة.

سنغوص في هذه المقالة الشاملة في عالم أحدث معماريات الذكاء الاصطناعي، ونستكشف السمات الرئيسية ونقاط القوة وتطبيقات المحولات (Transformers)، وJEPAs، وغيرها من النماذج المتطورة. سواء كنت من عشاق الذكاء الاصطناعي المخضرمين أو بدأت للتو في استكشاف هذا المجال الرائع، ستزودك هذه المقالة بنظرة عامة مفصلة ويمكن الوصول إليها لأحدث التطورات، مما يساعدك على التنقل في المشهد المتطور باستمرار للذكاء الاصطناعي.

صعود معماريات المحولات (Transformers)

سرعان ما أصبحت معمارية المحولات (Transformers)، التي تم تقديمها لأول مرة في الورقة البحثية الرائدة “الانتباه هو كل ما تحتاجه” (Attention is All You Need) من قِبل فاسواني وآخرون في عام 2017، واحدة من أكثر النماذج تأثيراً وانتشاراً في مجال معالجة اللغات الطبيعية (NLP). وعلى عكس الشبكات العصبية المتكررة (RNNs) والشبكات العصبية التلافيفية (CNNs) التقليدية، تعتمد المحولات (Transformers) على آلية فريدة تسمى “الانتباه” (attention) لالتقاط التبعيات بعيدة المدى والمعلومات السياقية داخل بيانات الإدخال.

يتمثل العنصران الأساسيان في صميم معمارية المحولات (Transformers) في: المُشفِّر (encoder) والمُفكِّك (decoder). يأخذ المُشفِّر (encoder) تسلسل الإدخال ويولد مجموعة من التمثيلات السياقية، بينما يستخدم المُفكِّك (decoder) هذه التمثيلات لتوليد تسلسل الإخراج، خطوة بخطوة. تلعب آلية الانتباه (attention) دوراً حاسماً في هذه العملية، مما يسمح للنموذج بالتركيز على الأجزاء الأكثر صلة من المدخلات عند توليد كل رمز إخراج.

تكمن قوة المحولات (Transformers) في قدرتها على التعامل مع التبعيات بعيدة المدى، وطبيعتها القابلة للتوازي، وقابليتها للتطوير لمجموعات بيانات أكبر وأكثر تعقيداً. جعلت هذه الميزات من المحولات (Transformers) الخيار الأمثل لمجموعة واسعة من مهام معالجة اللغات الطبيعية (NLP)، من الترجمة الآلية وتلخيص النصوص إلى نمذجة اللغة والإجابة على الأسئلة.

استكشاف معماريات التضمين المشترك التنبؤية (JEPAs)

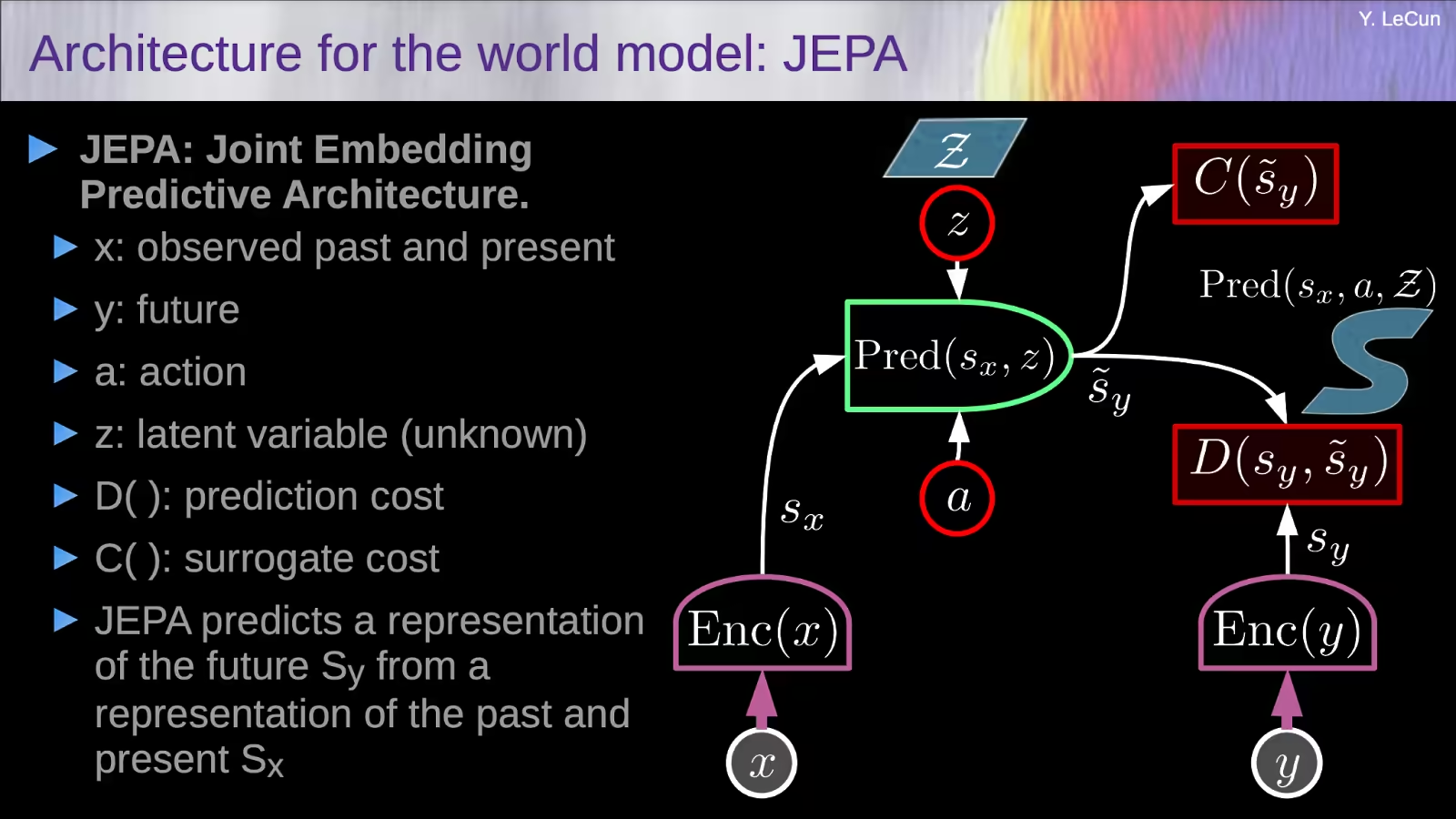

بينما سيطرت المحولات (Transformers) على مشهد معالجة اللغات الطبيعية (NLP)، ظهرت فئة جديدة من المعماريات التي من المتوقع أن تُحدِث ثورة في مجال التعلم الذاتي غير الخاضع للإشراف من الصور: معماريات التضمين المشترك التنبؤية (JEPAs).

تتمثل الفكرة الرئيسية وراء JEPAs في تعلم التمثيلات التي يمكنها التنبؤ ببعضها البعض عند تقديم معلومات إضافية، بدلاً من السعي لتحقيق الثبات لزيادة البيانات مثل الطرق التقليدية غير الخاضعة للإشراف. يشجع هذا النهج النموذج على التقاط ميزات ذات مغزى وعالية المستوى، بدلاً من التركيز على تفاصيل مستوى البكسل غير ذات الصلة.

أحد أبرز الأمثلة على JEPAs هو معمارية التضمين المشترك التنبؤية القائمة على الصور (I-JEPA)، التي قدمها باحثون في Meta AI. تعمل I-JEPA عن طريق أخذ كتلة “سياق” واحدة من صورة واستخدامها للتنبؤ بتمثيلات كتل “هدف” مختلفة داخل نفس الصورة. يسمح هذا النهج غير التوليدي للنموذج بتعلم تمثيلات على المستوى الدلالي دون الاعتماد على زيادة البيانات المصنعة يدوياً.

تُعدّ خيارات التصميم الرئيسية في I-JEPA، مثل استراتيجية الإخفاء واستخدام كتلة سياق موزعة مكانياً، ضرورية لتوجيه النموذج نحو توليد تمثيلات ذات مغزى وعالية المستوى. من الناحية التجريبية، ثبت أن I-JEPA قابلة للتطوير بدرجة عالية، مع القدرة على تدريب نماذج المحولات الرؤية (ViT) الكبيرة على مجموعة بيانات ImageNet في أقل من 72 ساعة مع تحقيق أداء قوي في المهام اللاحقة عبر مجموعة واسعة من المهام.

ما هي المزايا الرئيسية لاستخدام معمارية JEPA مقارنة بالنماذج التوليدية التقليدية؟

المزايا الرئيسية لاستخدام معماريات التضمين المشترك التنبؤية (JEPAs) مقارنة بالنماذج التوليدية التقليدية هي:

إعطاء الأولوية للتمثيلات الدلالية على تفاصيل مستوى البكسل

على عكس النماذج التوليدية التي تُركز على إعادة بناء بيانات الإدخال في مساحة البكسل، تتعلم JEPAs تمثيلات تتنبأ ببعضها البعض في مساحة تضمين مجردة. يسمح هذا للنموذج بإعطاء الأولوية لالتقاط ميزات دلالية ذات مغزى وعالية المستوى على تفاصيل مستوى البكسل غير ذات الصلة.

تجنب انهيار التمثيل

يمكن أن تعاني النماذج التوليدية أحيانًا من انهيار التمثيل، حيث يفشل النموذج في تعلم تمثيلات متنوعة وغنية بالمعلومات. تُعالِج JEPAs هذه المشكلة باستخدام تصميم غير متماثل بين أجهزة التشفير المختلفة، مما يشجع على تعلم التمثيلات التي يمكنها التنبؤ ببعضها البعض عند تقديم معلومات إضافية.

قابلية التوسع والكفاءة

يمكن أن تكون JEPAs، مثل معمارية التضمين المشترك التنبؤية القائمة على الصور (I-JEPA)، قابلة للتطوير وفعالة للغاية. على سبيل المثال، ثبت أن I-JEPA تُدرِّب نماذج المحولات الرؤية (ViT) الكبيرة على مجموعة بيانات ImageNet في أقل من 72 ساعة مع تحقيق أداء قوي في المهام اللاحقة.

التنوع في المهام اللاحقة

أظهرت JEPAs أداءً قوياً ليس فقط في المهام عالية المستوى مثل تصنيف الصور، ولكن أيضًا في المهام منخفضة المستوى والتنبؤ الكثيف، مثل حساب عدد الكائنات وتنبؤ العمق. يشير هذا التنوع إلى أن التمثيلات المُتعلَّمة يمكنها التقاط كل من الميزات الدلالية والموضعية بشكل فعال.

تتمثل المزايا الرئيسية لـ JEPAs على النماذج التوليدية التقليدية في قدرتها على إعطاء الأولوية للتمثيلات الدلالية، وتجنب انهيار التمثيل، وتحقيق قابلية التوسع والكفاءة، وإظهار التنوع عبر مجموعة واسعة من المهام اللاحقة. تجعل هذه الخصائص من JEPAs نهجًا واعدًا للنهوض بالحدود القصوى في التعلم الذاتي غير الخاضع للإشراف وبناء أنظمة ذكاء اصطناعي أكثر قدرة وقابلية للتكيف.

كيف تتعامل بنية المحول (Transformer) مع البيانات متعددة الوسائط مقارنةً ببنية JEPA؟

فيما يلي مقارنة لكيفية تعامل بنية المحول (Transformer) وبنية التضمين المشترك التنبؤية (JEPA) مع البيانات متعددة الوسائط:

بنية المحول (Transformer) للبيانات متعددة الوسائط

- تم تطوير المحولات (Transformers) في الأصل لمهام معالجة اللغات الطبيعية، ولكن تم توسيع نطاقها للتعامل مع البيانات متعددة الوسائط أيضًا.

- تقوم نماذج المحولات (Transformers) متعددة الوسائط عادةً بتشفير الوسائط المختلفة (مثل النص والصور والصوت) بشكل منفصل باستخدام أجهزة تشفير خاصة بكل طريقة، ثم دمج التمثيلات المشفرة باستخدام آليات دمج مثل التسلسل أو الانتباه.

- يسمح هذا لنماذج المحولات (Transformers) بالتقاط التفاعلات والعلاقات بين الوسائط المختلفة بشكل فعال.

- تتضمن أمثلة نماذج المحولات (Transformers) متعددة الوسائط VilBERT و VisualBERT و UNITER، والتي تم تطبيقها على مهام مثل الإجابة على الأسئلة المرئية واسترجاع الصور النصية.

بنية JEPA للبيانات متعددة الوسائط

- يُركز نهج JEPA (بنية التضمين المشترك التنبؤية)، الذي يُمثله نموذج JEPA المستند إلى الصور (I-JEPA)، على تعلم التمثيلات من طريقة واحدة (في هذه الحالة، الصور).

- تتعلم I-JEPA هذه التمثيلات من خلال التنبؤ بتمثيلات كتل الصور “المستهدفة” المختلفة من كتلة “سياق” واحدة، دون الاعتماد على زيادة البيانات المصنعة يدويًا.

- بينما لم يتم توسيع I-JEPA بشكل صريح للتعامل مع البيانات متعددة الوسائط حتى الآن، إلا أنه يمكن تطبيق مفهوم JEPA الأساسي لتعلم التمثيلات التنبؤية على طرق أخرى مثل النص أو الصوت.

- يمكن للعمل المستقبلي استكشاف توسيع JEPA لتعلم التمثيلات المشتركة عبر وسائط متعددة، على غرار كيفية عمل النماذج متعددة الوسائط المستندة إلى المحولات (Transformers).

تم تصميم بنية المحول (Transformer) بشكل أكثر وضوحًا للتعامل مع البيانات متعددة الوسائط من خلال تشفير كل طريقة بشكل منفصل ثم دمج التمثيلات، بينما ركز نهج JEPA حتى الآن على تعلم التمثيلات من طريقة واحدة. ومع ذلك، فإن الطبيعة التنبؤية لـ JEPA يمكن أن تجعلها مرشحًا واعدًا لتطوير بنى متعددة الوسائط في المستقبل.

معمارية مامبا (Mamba): نهج هجين

بينما حققت المحولات (Transformers) وJEPAs خطوات كبيرة في مجالاتها الخاصة، إلا أن هناك اهتمامًا متزايدًا باستكشاف المعماريات الهجينة التي تجمع بين نقاط القوة في المناهج المتعددة. أحد هذه الأمثلة هو معمارية مامبا (Mamba)، التي تهدف إلى الاستفادة من أفضل ما في العالمين.

مامبا (Mamba)، التي سميت على اسم الثعبان الرشيق والقابل للتكيف، هي بنية هجينة تدمج آليات الانتباه للمحولات (Transformers) مع إمكانات التضمين المشترك التنبؤية لـ JEPAs. من خلال الجمع بين هذين النموذجين القويين، تسعى مامبا (Mamba) إلى إنشاء نموذج أكثر تنوعًا وقوة يمكنه التفوق في مجموعة واسعة من المهام، من معالجة اللغات الطبيعية إلى رؤية الكمبيوتر وما بعدها.

تم تصميم معمارية مامبا (Mamba) لتكون معيارية للغاية، مما يسمح بالتكامل السلس للمكونات المختلفة والتكيف السهل مع طرق البيانات ومجالات المشاكل المختلفة. تجعل هذه المرونة من مامبا (Mamba) مرشحًا واعدًا لتطوير نماذج ذكاء اصطناعي “عامة” حقيقية، قادرة على معالجة مجموعة متنوعة من المهام والتحديات.

أحدث ما توصلت إليه التكنولوجيا في معماريات الذكاء الاصطناعي متعددة الوسائط

مع استمرار تطور مجال الذكاء الاصطناعي، أصبحت الحاجة إلى نماذج يمكنها التعامل مع دمج طرق البيانات المتعددة، مثل النص والصور والصوت والفيديو، بشكل فعال، واضحة بشكل متزايد. أدى ذلك إلى ظهور معماريات الذكاء الاصطناعي متعددة الوسائط، والتي تهدف إلى الاستفادة من المعلومات التكميلية من مصادر البيانات المختلفة لتعزيز الأداء العام وقدرات النظام.

أحد التحديات الرئيسية في تطوير معماريات الذكاء الاصطناعي متعددة الوسائط هو الدمج الفعال وتمثيل طرق البيانات المختلفة. استكشف الباحثون مجموعة من الأساليب، من التسلسل البسيط لميزات أحادية الوسائط إلى تقنيات أكثر تعقيدًا مثل الدمج القائم على الانتباه والتفاعل عبر الوسائط.

تتضمن الأمثلة البارزة لمعماريات الذكاء الاصطناعي متعددة الوسائط الحديثة المحول (Transformer) الشبكي الذاكرة لوصف الصور (M2 Transformer)، والذي يجمع بين قوة المحولات (Transformers) مع آلية جديدة قائمة على الذاكرة لتحسين كل من تشفير الصور وتوليد اللغة. مثال آخر هو نموذج ImageBind من Meta AI، والذي يسعى إلى إنشاء مساحة تضمين موحدة يمكنها ربط طرق مرئية ونصية مختلفة معًا.

مع استمرار تقدم مجال الذكاء الاصطناعي متعدد الوسائط، يمكننا أن نتوقع رؤية معماريات أكثر ابتكارًا وتنوعًا يمكنها دمج ومعالجة مجموعة واسعة من مصادر البيانات بسلاسة، مما يمهد الطريق لتطوير أنظمة ذكاء اصطناعي عامة حقًا.

الخاتمة

يشهد عالم الذكاء الاصطناعي حالة من التغير المستمر، حيث تظهر معماريات جديدة ومثيرة بوتيرة سريعة. بدءًا من نماذج المحولات (Transformers) الرائدة التي أحدثت ثورة في معالجة اللغات الطبيعية، ووصولاً إلى معماريات التضمين المشترك التنبؤية (JEPAs) المبتكرة التي تدفع بحدود التعلم الذاتي غير الخاضع للإشراف، تتطور معالم الذكاء الاصطناعي باستمرار، مما يتيح إمكانيات وتحديات جديدة.

في هذه المقالة، استكشفنا السمات الرئيسية ونقاط القوة وتطبيقات هذه المعماريات المتطورة، بالإضافة إلى الاتجاهات الناشئة في الذكاء الاصطناعي متعدد الوسائط. بينما نواصل دفع حدود ما هو ممكن في مجال الذكاء الاصطناعي، فمن الواضح أن المستقبل يحمل المزيد من التطورات الرائعة، مما سيُحوّل الطريقة التي نتفاعل بها مع العالم من حولنا ونفهمه.

سواء كنت من عشاق الذكاء الاصطناعي المخضرمين أو بدأت للتو في استكشاف هذا المجال الرائع، فقد زودتك هذه المقالة بنظرة عامة مفصلة ويمكن الوصول إليها لأحدث التطورات، مما يزودك بالمعرفة والرؤى اللازمة للتنقل في المشهد المتطور باستمرار للذكاء الاصطناعي.